Hvornår bliver syntetisk oplæsning god nok?

Flere og flere lytter til artikler. Men indtaling tager tid, og det koster. Selvom der er enighed om, at kunstig oplæsning ikke er god nok lige nu, viser studier, at maskinstemmer allerede nu er bedre end visse menneskestemmer i nogle situationer.

Af Lars K Jensen / lars@willmore.dk

(Følg Lars på Twitter / LinkedIn)

✨ Artiklen er opdateret:

- Mandag den 7. december kl. 13:40 med Google WaveNet.

- Søndag den 6. december kl. 19:45 med Lyrebird – der nu er en del af Descript.

Artiklen fortsætter herunder ↓

Bliv bedre til dit arbejde.

Følg og forstå de digitale medietendenser med Digital Ugerevy:

Du modtager én mail om ugen med interessante indblik + min ugentlige opsamling på ugens vigtigste trends og historier.

Det går op for flere og flere tekstbaserede medier, at de er nødt til at have en lydudgave af deres indhold. Senest er Berlingske begyndt at eksperimentere, mens den måske største succeshistorie herhjemme er Zetland, der nu ser sig selv som et skrevet medie, der også bliver lyttet.

Derudover har Weekendavisen Lydavisen, hvor du kan lytte til artiklerne fra ugens avis, og vi kommer helt sikkert til at se flere medier servere deres artikler som lyd.

Det er der flere gode grunde til. For det første fordi, det bliver lettere for mange at konsumere indholdet. Du kan lytte, mens du vasker op, laver mad, kører i bil eller offentlig transport, går en tur – ja, the list goes on.

En strategi for lyd

Jeg har tidligere plæderet for, at danske medier bør have en strategi for lyd:

“Det interessante ved det her er, at det sker, fordi modtageren vil have det. Ikke fordi afsenderen (typisk et medie) synes, det er spændende. Vi kan være på vej et sted hen, hvor man er nødt til at tilbyde sit indhold som lyd, hvis man vil øge sandsynligheden for at det bliver modtaget og konsumeret.

Jeg mener ganske enkelt, at danske medier bør overveje at have en strategi for lyd. En strategi, der går udover det, at have en række podcasts, som flere medier efterhånden har. Disse podcasts lever (som det er mange steder nu, i hvert fald) ved siden af det indhold, der bliver udgivet på hjemmesiden – kerneindholdet. Jeg tror, man bliver nødt til at have det indhold repræsenteret på lydsiden også.”

Men det er ikke gratis at udkomme lyd på. Det koster både tid og ressourcer til udstyr, faciliteter og det tekniske setup, der gør det smidigt for brugeren at lytte til artikler, der hvor det giver allermest mening for ham/hende.

Derfor holder mange medier et vågent øje med udviklingen indenfor syntetiske stemmer. Det vil sige, hvor det er en algoritme, der skaber en oplæst udgave af en artikel ud fra nogle definerede parametre, der gør det mere eller mindre fantastisk at lytte til.

AI hæver niveauet

Tekst-til-lyd er bestemt ikke nogen ny teknologi. Jeg kan huske, hvordan jeg i folkeskoleårene i 1990erne eksperimenterede med at hælde sætninger ind i et program og fik det læst op. Men det var bestemt ikke noget, man kunne holde ud at lytte til i længere tid.

Og i mange år har blinde og svagtseende kunnet få tekster læst op på eksempelvis offentlige websites, men det har været langt fra den oplevelse, det er at lytte til et menneske, der snakker.

Landvindingerne nu hænger sammen med udviklingen indenfor kunstig intelligens, og derfor er nu et rigtig godt tidspunkt at holde øje med udviklingen.

Jysk Fynske er i gang

Lige nu er der ret bred enighed – i hvert fald i den danske mediebranche – om, at de syntetiske stemmer ikke er gode nok.

Der er dog nogle, der forsøger sig med teknologien.

I juli måned lancerede Jysk Fynske Medier automatiseret oplæsning af artikler i samarbejde med virksomheden Speechkit. Hvordan det lyder, kan du høre i denne artikel om marsvinet Eskild.

Min umiddelbare dom er, at det sikkert er fint nok til en kort opdatering, men jeg tror ikke, jeg kan holde til den stemme igennem en hel artikel. Men de prøver – og det er med til at skabe opmærksomhed, der er med til at presse udviklingen videre, indtil vi lige pludselig har noget, der er godt nok til rigtig mange danske mediebrugere.

Den store udfordring for os danskere er selvfølgelig vores sprog, der ikke tales af ret mange andre end os selv. Derfor er vi enten nødt til at vente på, at de virksomheder, der udgør fortroppen kommer til os på deres liste over lande – eller at nogle med dansk fokus udvikler en teknologi, der er stærk nok.

Amazon læser nyheder

Men kigger vi på udviklingen indenfor oplæsning af engelsk indhold, sker der interessante ting. I juli 2019 præsenterede Amazon en stemme, der skal lyde som en nyhedsoplæser.

Den kan du høre et eksempel på her:

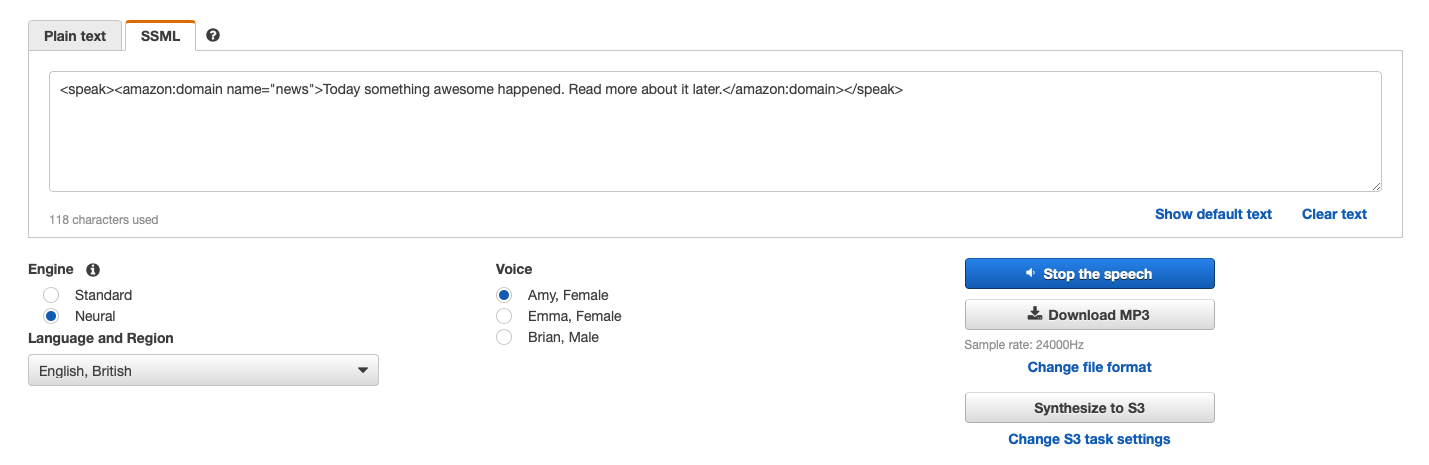

Nu begynder det rent faktisk at lyde som noget, man godt kan forestille sig at lytte til, også i længere tid. I november 2020 lancerede Amazon så endnu en nyhedsoplæserstemme – denne gang en, der taler britisk engelsk.

Jeg kastede lige hurtigt en engelsk tekst ind i den britiske nyhedsoplæser i Amazons Polly-konsol:

Resultatet kan høres her:

Automatisér din egen stemme

Nogle, der er langt fremme i bussen, er Lyrebird, som Magnus Bjerg fra TV 2 mindede mig om på Twitter (tak, Magnus!).

De har eksisteret i nogle år (de lavede blandt andet en syntetisk Trump i 2017) og er nu en del af Descript, hvor deres teknologi blandt andet bruges til at lave din egen stemme syntetisk (de kalder funktionen ‘Overdub‘), så du nemt kan redigere speaks etc.

Jep, det lyder pænt cool. Jeg har endnu ikke selv prøvet produktet, men reklamevideoen fra Descript får det i hvert fald til at se interessant ud. Teknologien giver i hvert fald en masse interessante idéer – den klarer dog næppe skiftet til dansk særlig godt, gætter jeg umiddelbart på.

Derudover praler Descript med, at de er de eneste, der leverer syntetisk tale i broadcast-kvalitet (44.100 Hz).

(Descripts overtagelse af Lyrebird betyder desværre, at mange URL’er og links til gamle eksempler ikke længere virker 😔.)

Google WaveNet

Google er også blandt dem, der er langt fremme. De har en text-to-speech-teknologi, der baserer sig på AI-pionererne Deepmind, som Google købte tilbage i 2014 (tak for tippet til Søren Pedersen).

Særlig interessant er WaveNet-modellen, der den, der leverer stemmerne til blandt andet Googles smarte assistent og Google Translate. “It represents a new way of creating synthetic speech,” skriver Google selv:

“A WaveNet generates speech that sounds more natural than other text-to-speech systems. It synthesizes speech with more human-like emphasis and inflection on syllables, phonemes, and words. On average, a WaveNet produces speech audio that people prefer over other text-to-speech technologies.”

Under WaveNet-modellen ligger et neuralt netværk, der er trænet på en stor mængde stemmeoptagelser. Her har teknologien lært den underliggende struktur i talen, samt hvordan tonen skal lyde, og hvordan en realistisk bølgeform for tale ser ud.

Som ved flere af de andre, blandt andet Amazon Polly, kan man kalde WaveNet programmatisk via et API.

Pocket: Læs eller lyt senere

Jeg kan også lytte til de artikler, jeg gemmer i Pocket. Mens jeg skriver dette, står jeg og lytter til en artikel i Pocket. Jeg kan godt høre, det ikke er et menneske, der læser op – men hvis det er en artikel, jeg skal have læst – og som jeg ikke får læst på tekst – er vi ved at være rigtig tæt på noget, der er godt nok.

En fin lille detalje i Pocket er, at den bruger én stemme til at introducere artiklen og en anden til at læse den op. Det er snedigt set.

Men man kan sagtens høre, at Pockets oplæsning er kunstig. Og fordi meget lytning foregår når folk er på farten eller i en privat kontekst, sker det ofte via hovedtelefoner eller in-ear-øretelefoner. Her er vi så tætte på lyden, at selv små fejl fremstår tydeligere, end når man lytter på fx en bluetooth-højttaler.

Den automatiske oplæsning hos Breitbart bruger en smart detalje: Det lyder som om, den kunstige oplæser trækker vejret. Det gør, at det virker mere menneskeligt. (Tak for tippet, Tore Julø – advarsel: der er grimt sprog i det eksempel. Så er du advaret…)

Blandede erfaringer

Men hvad siger erfaringerne? I februar 2020 gjorde Nieman Lab status (tak til Martin Ingolf for at tippe mig om den artikel) på lydartikler, hvor de blandt andet nævner Zetland.

Men de skriver også om syntetisk oplæsning, hvor de deler erfaringerne fra et virksomhed, der specialiseret sig i netop dette:

“Right now, the incentives to build an app around synthetic narration of news articles aren’t quite there. Play.ht founder Hammad Syed says his app grew out of a web browser extension that turned articles into automated speech. Unable to make it sustainable, Syed converted Play.ht to a service for publishers, encouraging bloggers, and other writers to pay for Play.ht to create narration or podcasts of their articles.

‘A lot of people engage with the audio, but almost half of them, they stopped before even completing 25%,’ Syed says. When Syed asked users why they stopped listening, the most common response was that the speech sounded too mechanical.”

Derfor kan brugerne af Play.ht nu, skriver Nieman Lab, ændre på små indstillinger, der ændrer på rytmen i oplæsningen, så den bliver mindre mekanisk.

Det afhænger også af, hvilken teknologi og stemmetype, der bliver brugt.

I år var Julia Cambre, der er PhD-studerende Human-Computer Interaction Institute på Carnegie Mellon University og tidligere har arbejdet for blandt andet Mozilla, med til at skrive en artikel, der kigger på kvaliteten i maskinoplæsning af artikler.

Og her er der spændende nyt til teknologer og andre, der venter på syntetisk tale (min fremhævning):

“Perhaps unsurprisingly, we found that human voices still largely outperform TTS voices. On almost all quality dimensions we studied, including Mean Opinion Score (MOS), overall positive quality ratings, clarity, quality, and voice speed, two of the human voices consistently received higher ratings than all TTS voices. However, several of the TTS voices consistently performed better than one of the human voices (Human 2).

While using natural (recorded) human speech has traditionally been considered preferable to using synthesized speech, these results suggest that there are indeed situations where a high-quality TTS voice may be preferable over certain human voices. The relatively small differences in quality ratings be- tween the highest performing TTS voices and the top human voices also reflects the increasing sophistication of today’s speech synthesis technology. Computerized voices are nearing or exceeding certain human speakers, and TTS voices may soon reach parity with human speech in naturalness, expressivity, and so on, making them an even more viable option for long-form listening than they are at present.”

Altså: Der er ved at være situationer, hvor syntetiske stemmer er bedre end (nogle) menneskelige. Det vil især være interessant for de medier og andre, der ikke har penge eller ressourcer til at lade stemmetrænede speakere med behagelige stemmer stå for oplæsningen.

Forberedelsen starter nu

Og så bør vi lige bide mærke i, at testene i studiet blev gennemført fra midten af 2018 til midten af 2019. Derfor er Amazons “newscaster”-stemmer med stor sandsynlighed ikke inkluderet.

Det er værd at huske på, at vi her kigger ind i en udvikling på engelsk. Dansk talesyntese er stadig et stykke bagefter, så der vil gå noget tid, inden vi får gavn af de landvindinger, der bliver gjort lige nu.

Men det kommer, og det er kun et spørgsmål om tid, før vi får kunstige stemmer på dansk, der er gode nok.

Derfor skal anbefalingen herfra også være, at man kommer i gang med at eksperimentere. Oplagt kan man oversætte nogle af sine artikler til engelsk og eksperimentere med at få dem læst op af noget af den mest avancerede stemmeteknologi, der er til rådighed lige nu.

De erfaringer er gode at have, når de danske robotstemmer når det rette niveau. ◉